AR眼镜是什么原理?深入解析增强现实的核心机制

随着数字化技术的普及,AR眼镜(增强现实眼镜)逐渐从概念走向实际应用。对于企业用户而言,了解 AR眼镜的工作原理,不仅有助于设备选型与技术落地,更是推动工业智能化、远程协作及可视化管理的重要基础。

一、AR眼镜的核心原理概述

AR眼镜的核心原理在于“将虚拟信息与现实世界进行融合”。

它通过 光学显示、传感识别、空间计算和交互控制等多项技术,将虚拟内容精准叠加在用户视野中,实现虚实共存的视觉体验。

换句话说,AR眼镜并非替代现实,而是在用户看到的真实场景中“叠加”数字信息。例如,工程师佩戴AR眼镜查看设备时,可以看到实时参数、操作指导或远程专家标注,从而提升操作效率。

二、AR眼镜的技术组成与工作机制

要理解AR眼镜的原理,需要从其技术结构入手。整个系统可分为五大核心模块:

1. 光学显示系统

光学显示是AR眼镜的核心,它决定了虚拟画面如何呈现在人眼前。常见的显示技术包括:

波导显示(Waveguide):通过光波导导入图像,使虚拟影像叠加在真实场景中。

自由曲面光学(Freeform Optics):利用特殊透镜设计实现更大视场角与更高透过率。

Micro-OLED 或 LCoS 显示屏:提供高分辨率与低功耗的影像源。

这些技术确保AR画面在光照强烈的环境下依然清晰可见,并具备自然的成像深度。

2. 传感器系统

AR眼镜内置多种传感器,用于感知环境与用户状态,包括:

IMU传感器(陀螺仪、加速度计、磁力计):用于追踪头部姿态与运动。

深度摄像头/ToF传感器:用于空间测距与环境建模。

视觉传感器(RGB摄像头):识别物体、标识与手势动作。

这些传感器协同工作,使AR眼镜能够“理解”用户所在环境,准确识别空间位置与物体边界。

3. 空间计算与SLAM算法

AR眼镜的关键能力在于“空间感知”。这依靠 SLAM(即时定位与地图构建)算法来实现。

SLAM通过实时采集环境图像与传感数据,计算用户位置和周围物体关系,从而在虚拟空间中建立对应的三维地图。

这使得虚拟内容(如指示箭头、标签或设备说明)能够精准地固定在现实物体上,不随视角移动而漂移。

4. 交互与控制系统

AR眼镜的操作方式多样,通常支持:

语音控制:通过语音识别实现免手动操作;

手势识别:通过摄像头识别手部动作实现自然交互;

视线追踪(Eye Tracking):识别用户注视点,提升交互精度;

外部控制终端(如手机或PC):用于远程操控与数据同步。

这种多模态交互方式,使用户在复杂环境中依然能高效控制AR界面。

5. 计算与通信模块

AR眼镜通常搭载嵌入式处理器或与云端服务器协同计算,以支持图像渲染、AI识别及远程协作功能。

部分工业级AR眼镜还支持 自组网通信、Wi-Fi 6、5G 低延迟传输,以实现多设备间的实时协同与数据共享。

三、AR眼镜原理在工业应用中的体现

AR眼镜的工作原理在不同行业场景中有着具体体现:

在设备巡检中,通过空间识别叠加实时操作指令,实现标准化作业。

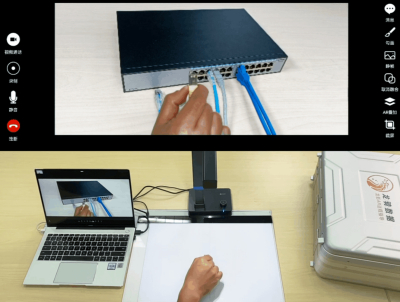

在远程维修中,通过视频融合与动作捕捉技术,让远程专家“看到”现场情况并实时指导。

在培训教学中,利用虚拟叠加展示复杂装配步骤,提高学习效率。

对于企业而言,这种原理的本质优势在于将“知识数字化”、“操作可视化”、“指导实时化”,从而实现降本提效与安全保障。

四、AR眼镜原理的发展趋势

未来,AR眼镜的技术原理将继续向以下方向演进:

AI驱动的智能识别:通过AI视觉算法自动识别设备、场景与人员;

轻量化与低功耗设计:提升佩戴舒适度与续航性能;

更广的FOV与更自然的虚实融合:提升视觉沉浸感;

国产化算法与硬件体系:强化自主可控与行业适配能力。

这些趋势将推动AR眼镜在工业、能源、制造、教育等领域的深入应用。

五、龙影AR:以国产化创新推动AR技术应用

在企业级AR领域,龙影AR以自研的动作捕融技术和AR远程协作平台为基础,持续优化设备性能与应用体验。

系统支持多平台适配(Android、iOS、Web),结合自研高精度捕融仪,实现毫米级动作捕捉与视频融合,助力企业实现更精准的远程指导与现场操作协同,为AR眼镜的原理应用提供坚实支撑。